ブログ

AIエージェントの法的留意点 AIガバナンス ―AIガバナンスの必要性から手法、実践まで―

2026.02.19

はじめに

第4回(前回)のブログでは、AIエージェントの利用段階に焦点を当て、インプットとアウトプットに内在する法的及び実務上のリスクを整理し、「何を入れ、何が出るか」を可視化し、適切に人間の関与と技術的な制御を組み合わせて運用していくことが重要であることを述べました。

AIエージェントについては、MIT Sloan Management ReviewとBoston Consulting Groupが共同で行った調査によれば、登場からわずか2年で35%の企業がAIエージェントを導入しており、44%の企業がAIエージェントを近く導入予定であるという結果が出ており[i]、今後も、AIエージェントの開発や利用に興味を持つ企業が増加していくと考えられます。

これまでのブログでは、個別論点ごとの整理として静的な視点で、AIエージェントの法的リスクについて検討してきましたが、AIエージェントの開発や利用を行う企業としては、日々の業務の中で、どのように開発又は利用するAIエージェントのリスクを管理していくかが問題となります。本ブログでは、このようなAIエージェントのリスクマネジメント(ガバナンス)について取り上げたいと思います。[ii]

本ブログの要点

- AIガバナンスの「守り」と「攻め」

AIガバナンスには、その自律性に伴うリスクを管理する「守り」の側面だけでなく、人間の介入やフィードバックを通じて回答精度やサービス価値を向上させる「攻め」の側面もあります。

- AIガバナンスの手法-「アジャイル・ガバナンス」

総務省・経済産業省の「AI事業者ガイドライン(第1.1版)」では、技術や社会環境の急速な変化に対応するため、固定的なルール運用ではなく、経営層と現場の双方向でフィードバックループを回し続ける「アジャイル・ガバナンス」の採用が推奨されています。

- AIガバナンスの実践

環境・リスク分析に基づき、AIエージェントの開発・提供・利用の可否を検討します。その上で実施に進む場合には、リスクの評価に基づいて、技術的対策に加え、Human-in-the-loop(人間による関与)等のルール整備に関わる法務面や、フィードバックループが機能するような体制面の対策を組み合わせて対応を行います。

AIガバナンスの必要性

(1) AIガバナンスの守りと攻めの側面

第4回(前回)のブログで述べたとおり、AIエージェントの利用段階のアウトプットについては、同じ入力でも出力が一定せず、不可避的に揺れが生じ、インプットについても、各種法令との関係で検討が必要になる場合があります。

このようなAIエージェントの特性から、二つの意味で、AIガバナンスが必要といえます。すなわち、①AIエージェントのリスクを管理するという守りの意味と、②AIエージェントの質を向上させるという攻めの意味があります。前述のMIT Sloan Management ReviewとBoston Consulting Groupが共同で行った調査の報告書でも、AIエージェントの適切なガバナンスを構築できなければ、法令違反や質の低いアウトプット、業務への悪影響などに至るおそれがある(①の側面)一方で、AIエージェントを適切に管理することができれば、人的制約を超えて、質の高い能力を拡張していくことができる(②の側面)と指摘されています。[iii]

具体的には、①AIエージェントのリスクを管理する点については、第4回(前回)のブログで述べたとおり、利用段階のインプット及びアウトプットについて、それぞれ法的なリスクがありますので、これらをコントロールする必要があります。また、AIエージェントを開発する企業としては、利用段階だけではなく、第2回と第3回のブログで述べたように、開発契約におけるリスクや、自社のAIエージェント製品による事故等によるリスクなどもコントロールする必要があります。

次に、②AIエージェントの質を向上させる点については、例えば、AIガバナンスとして、AIエージェントのアウトプットをそのまま利用するのではなく、人間の判断を介在させて、AIエージェントのアウトプットを吟味するプロセスを採用した場合を想定します。この場合、AIエージェントのアウトプットに誤りがあったり、質が低かった場合に、フィードバックを行い、AIエージェントの質の向上につなげることができます。他方で、適切なAIガバナンスを行わず、導入時など特定の時点でのみリスク評価を行うのでは、このようなAIエージェントの質の向上を図る機会が失われてしまいます。AIガバナンスを行うことは、AIエージェントの提供する価値の向上につながる可能性を秘めているといえます。しかも、「AI倫理の対応度合いはAIの品質なのである」という指摘もあるとおり[iv]、適切なAIガバナンスを行うことによって、自社の製品・サービスが市場に受け入れられやすくなる可能性もあるといえます。

したがって、AIエージェントについては、守りと攻めの両面において、AIガバナンスが必要です。

(2) AIガバナンスを必要とする企業

前記(1)で述べたAIガバナンスの意味からすれば、AIガバナンスは、AIエージェントを開発・提供する企業だけではなく、AIエージェントを利用する企業にも必要です。

経済産業省の「AI事業者ガイドライン(第1.1版)」(以下「AI事業者ガイドライン」といいます。)も、様々な事業活動においてAIの開発・提供・利用を担う全ての者を対象としています。その上で、それぞれの主体において、「AIに関するリスクをステークホルダーにとって受容可能な水準で管理しつつ、そこからもたらされる便益を最大化するための、AIガバナンスの構築が重要となる」と指摘されています。[v]

ただし、AIの開発・提供・利用を行う者が全て同じレベルでAIガバナンスの構築が必要というわけではありません。リスク管理の観点からは、AI開発者及びAI提供者は、AIを開発又は提供することから、社会全体に与える影響が大きい[vi]のに対し、AI利用者は、社会全体に与える影響は必ずしも大きくありません。また、質を向上させる観点からは、AI開発・提供・利用のそれぞれにおいて、求められる質の内容や取り得る方策が異なります。それぞれの立場において、AIガバナンスの考え方を踏まえて、最適なガバナンスを構築していく必要があります。

AIガバナンスの手法

AIガバナンスにおいては、AIエージェントを取り巻くさまざまなファクターが変化していく可能性があります。

例えば、AI利用企業であれば、さまざまなAIエージェントのツールが現れており、現在利用しているツールだけではなく、将来的には利用するツールも変化していくことが想定されます。

また、AIエージェントに対する社会の意識も変化していくと考えられます。

さらに、例えば、営業代行のAIエージェントを想定すると、①AIエージェントを実際に利用して営業を行う企業、②AIエージェントのシステムを提供する企業、③AIエージェントのシステムを開発する企業、④AIエージェントのシステムに基盤モデルを提供する企業と、一つのAIエージェントのバリューチェーンに多くの主体が関与することが考えられます。そのため、バリューチェーン上の一つの主体に起きた変化が、多くの主体に波及して影響していきます。[vii]

このように、AIエージェントを取り巻くさまざまなファクターが変化していく可能性があるため、そのような変化を前提として対応していくガバナンスが必要になります。

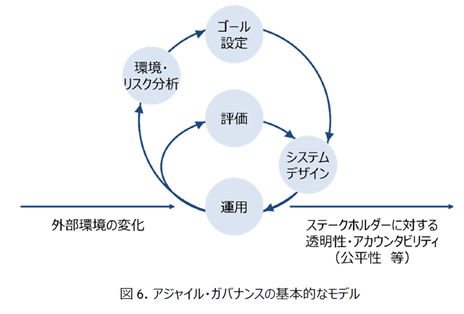

そこで、AI事業者ガイドラインにおいては、ガバナンスの内容を常にアップデートし続ける体制を構築するという観点から、以下の図のように、経営層レベルでのフィードバックループと、現場レベルでのフィードバックループの二重のループを回していく、「アジャイル・ガバナンス」が推奨されています。

(総務省・経済産業省「AI事業者ガイドライン(第1.1版)」(2025年3月28日)28頁から引用)

AIガバナンスの実践

(1) 環境・リスク分析

AIエージェントの導入を検討するに当たり、まずは自社の置かれた環境に即して、どのような便益があり、どのようなリスクがあるかを把握する必要があります。

リスク評価においては、AI事業者ガイドラインで「共通の指針」として掲げられている人間中心の原則や安全性、公平性などの観点が参考になります。また、EUのAI規則において、差別につながるようなAIは「許容されないAI」として分類されていることや、個人のプロファイリングを行うAIが「高リスクAI」として分類されていることなど、AIの類型ごとにどのようなリスク評価が行われているかも参考になります。

また、環境評価においては、自社内だけではなく、AIエージェントの開発・提供・利用で影響を受ける可能性のあるステークホルダーの考え方も調査することが望ましいといえます。

このような環境・リスク分析を経て、AIエージェントの開発・提供・利用に進むかを判断します。

(2) 方針の策定

環境・リスク分析に基づき、まずはAIエージェントの開発・提供・利用の可否を検討します。その上で、実施に進む場合には、AIポリシーの策定等によって、AIガバナンスのゴールを設定することが考えられます。AIポリシーを策定して公表することは、企業としての真摯な姿勢を示す対外的・対内的なシグナルとなります。その上で、AIポリシーは、一度定めたら終わりというものではなく、自社の今後のAI活用の指針となるものであり、環境の変化に応じて継続的に修正・改善されていくべきものです。

具体的に方針に取り込むべき内容としては、各社の方針によるところが大きいものの、AI事業者ガイドラインを参考にして、人間中心の原則などのAIエージェントを開発・提供・利用する上で尊重する価値や、そのためにどのような体制を構築するか、また、AIエージェントを開発・提供・利用することで、どのような価値を顧客や社会に提供するかなどについて記載することが考えられます。

(3) 体制構築・運用

具体的な体制構築と運用では、リスク評価を行い、それに基づいて対応の決定・実施を行うサイクルを構築することがポイントです。

まず、例えば、AIエージェントを利用する事業者であれば、利用しようとする個々のAIツールや利用方法ごとに、その便益とリスクを評価します。リスクの評価は、一般的に「重大度」×「発生確率」の掛け合わせで行います。

次に、評価されたリスクに対して、どのような対応を取るかを決定します。対応の類型としては以下の四つが考えられます。[viii]

リスクの保有:リスクを受け入れてプロジェクトを進める

リスクの軽減:組織のルール、技術的対策、体制整備によってリスクを下げる

リスクの移転:契約や保険によってリスクを第三者に移転・共有する

リスクの回避:リスクが大きすぎる場合、プロジェクト自体を諦める

(4) 運用のケーススタディ:人事評価での活用

具体的なイメージを持つために、「人事評価」でAIエージェントを活用する場合を例に考えてみます。本ブログでは、事例を単純化するために、AIエージェントの出力にバイアスが含まれ、公平性を欠く評価が行われるという「倫理上のリスク」に絞って検討します。

倫理上のリスクについては、技術テストや法務的な検討を経て、特定したリスクの「重大度」×「発生確率」を見極めることが重要です。重大度の観点では、公平性を欠いた人事評価が行われた場合のリスクは相応に大きいといえます。他方で、発生確率については、技術テストの結果を踏まえて判断することになります。

上記のようなリスク評価を経て導入を決定した場合には、バイアスや公平性のリスクに対しては、次のようなリスクの軽減策が考えられます。

例えば、技術面では、システムプロンプトやファインチューニング、ガードレールの設定などにより、バイアスを取り除いたり、問題のあるアウトプットが出ないような対応を行うことが考えられます。

また、法務面では、技術的に対応できない点についてカバーするルールを作成したり、必ず人間が最終確認・修正を行う「Human-in-the-loop」のルールを整備することなどが考えられます。

さらに、体制面では、公平性の問題が生じていないか定期的に監査を行ったり、現場から報告・改善ができる体制を構築することが考えられます。

これらのリスクへの対応は、技術、法務、ビジネスの要素が絡み合うため、単独の部門では対応できず、各部門が協働するチームを組成することが肝要です。

まとめ

本ブログでは、AIエージェントの「AIガバナンス」について、その必要性と実践的な手法を解説しました。

AIエージェントは、自律的にタスクを遂行し、学習や環境変化に応じて出力が変動し得る特性を持っています。そのため、組織全体として継続的にリスクを監視・評価し、改善し続ける「線(プロセス)」としてのガバナンス体制が不可欠です。

次回以降は、経済産業省の「AI利活用における民事責任の在り方に関する研究会」[ix]において議論されている内容を踏まえて、AIエージェントと民事責任について説明します。

以上

[i] S. Ransbotham, D. Kiron, S. Khodabandeh, S. Iyer, and A. Das, “The Emerging Agentic Enterprise: How Leaders Must Navigate a New Age of AI,” MIT Sloan Management Review and Boston Consulting Group, November 2025, https://web-assets.bcg.com/dc/c5/1bcbfdc0405c85fb14972a57c20a/the-emerging-agentic-enterprise-how-leaders-must-navigate-a-new-age-of-ai.pdf。なお、生成AIについては、3年で70%の企業が導入するに至っていることも指摘されています。

[ii] AIリスクマネジメントやAIガバナンスについて明確な定義があるわけではありませんが、同じような意味で使われることもあるため、本ブログでは、いずれもAIのリスクをどのように管理するかという問題として捉えて検討します。

[iii] 前掲注i)10頁参照

[iv] 桑野雄一郎、澤田将史、田邉幸太郎、殿村桂司、中崎尚、古川直裕「相談事例で学ぶ 生成AIの活用と法務」(有斐閣、2025年)25頁

[v] 経済産業省「AI事業者ガイドライン(第1.1版)」(2025年3月28日)4、27頁、https://www.meti.go.jp/shingikai/mono_info_service/ai_shakai_jisso/pdf/20250328_1.pdf

[vi] 前掲注v)30、35頁

[vii] 羽深宏樹「AIガバナンス入門」(ハヤカワ新書、2023年)121-122頁

[viii] 前掲注vii)131-134頁

[ix] https://www.meti.go.jp/shingikai/mono_info_service/ai_utilization_civil/001.html

Member

PROFILE